Son publicadas nuevas fotos, esta vez a color, de Plutón tomadas por la sonda New Horizons. Además se explica cómo son obtenidas.

|

Los investigadores a cargo de la misión New Horizons a Plutón están recibiendo más fotos de Plutón que rápidamente publican en la página web de la NASA.

Cuando ya estábamos sorprendiéndonos con las fotos en blanco y negro que se habían enviado recientemente, ahora ya tenemos fotos muy buenas a todo color.

Quizás lo primero haya que explicar es cómo las sondas espaciales de la NASA consiguen estas y otras fotos, a color o en blanco y negro.

En nuestras cámaras digitales, que ya todos ya tenemos, existe un sensor que cumple el papel que tenía la película química. Al incidir la luz sobre el sensor se acumula una carga sobre los semiconductores de los que está hecho este chip, carga que puede ser leída.

El chip está estructurado en una matriz rectangular de fotodiodos y cada uno de estos fotodiodos va a proporcionar la información sobre la intensidad de luz de un píxel de la imagen final.

Si la exposición a la luz sobre un fotodiodo es excesiva, entonces este se satura con el valor máximo de carga y no hay más información contenida en él que una cota que se ha superado. Si la luz que llega es demasiado poca entonces la relación señal/ruido es baja y no se obtiene detalle en ese punto de la foto que corresponde a una sombra en la imagen, pues el ruido electrónico es superior a la señal producida por la luz.

La capacidad de poder registrar detalles en las luces y sombras a la vez en una misma imagen es denominada latitud, concepto al que también se llama intervalo o gama dinámica (y que a veces se llama rango dinámico cuando está mal traducido por algún ignorante). Interesa que esta latitud sea lo más grande o amplia posible.

La sensibilidad de un sensor dependerá del área de cada fotodiodo. A mayor área del fotodiodo mayor sensibilidad y mayor latitud. Sin embargo, para un área total de sensor dada, cuantos más fotodiodos metamos más resolución tendremos (más Megapíxeles en la imagen final), pero menos área por fotodiodo y menos sensibilidad y latitud tendremos.

En esto de la fotografía pasa lo mismo que en la vida, no se puede tener todo a la vez porque, a veces, ciertas cosas son incompatibles entre sí.

Además, cuanto más pequeño sea el fotodiodo más fácil que no funcione debido a que las técnicas fotolitográficas que se emplean en su confección no son perfectas. En los sensores de nuestras cámaras hay píxeles muertos, píxeles correspondientes a fotodiodos que no funcionan y cuyo valor de luz es sustituido por software copiando los valores de los píxeles vecinos correspondientes a fotodiodos funcionales.

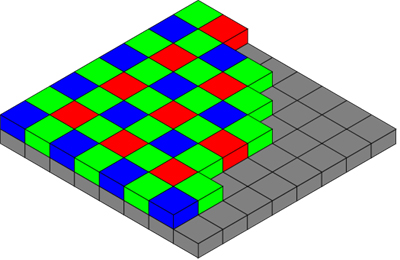

Hasta ahora sólo hemos descrito cómo se obtiene una foto en blanco y negro. Pero nuestras cámaras producen fotos en color, ¿cómo lo consiguen? Fácil, sobre cada fotodiodo hay un filtro de color correspondiente a los colores primarios rojo, verde y azul (RGB). Al tratarse de una matriz rectangular, la distribución de estos 3 colores sobre 4 puntos es un tanto curiosa. Se colocan 2 filtros verdes por cada filtro rojo y por cada filtro azul. Es lo que se llama un patrón de tipo bayer. Se supone que el color verde porta más información porque nuestros ojos son más sensibles a él y por eso es el verde el que se repite.

|

Pero, vamos a ver, si tengo 4 píxeles correspondientes a 3 colores ¿cómo se consigue una imagen final en la que cada píxel tiene los tres valores correspondientes a cada color para así tener el color mezcla final? De nuevo se recurre al software y se interpola o se reconstruyen los valores de intensidad de luz y color para cada píxel usando la información de sus vecinos en un proceso que se puede llamar desbayerización. Es decir, parte de la información se deduce (¿inventa?).

Y lo que es más, al colocar estos filtros de color sobre los fotodiodos se reduce la cantidad de luz que llega al mismo, por lo que es menos sensible.

Sobre todo el sensor se coloca, además, un filtro infrarrojo que elimina esa parte del espectro a la que el sensor es también sensible. De hecho, si se usa óptica de cuarzo y no se ponen filtros ultravioleta, los sensores de nuestras cámaras también son sensibles al espectro ultravioleta.

A los científicos les interesa que los sensores se las sondas espaciales sean sensibles, pues, por ejemplo, Plutón está muy lejos del Sol y no le llega mucha luz. Además interesa que no haya píxeles muertos, es decir, que no haya pérdida de información. Por lo tanto, los sensores son de baja resolución y sin filtro bayer. Son en blanco y negro.

¡Pero oiga usted!, se podría decir, ahora contamos con sensores que tienen unas prestaciones superiores a esos que porta la NH, sobre todo si se usan tan cual sin filtro bayer.

Sí, esto es verdad ahora, pero no hace 15 años cuando se diseñó la misión, ni hace 10 cuando se lanzó. Además, la electrónica (incluidos los chips de imagen) tiene que estar homologada para viajar al espacio, pues la radiación del espacio puede inutilizarla. No puede lanzar su Iphone al espacio y esperar que funcione.

Es decir, los sensores de imagen que porta la NH son lo mejor que había en su día para una misión de este tipo.

Sí, vale, pero entonces las imágenes a color de NH, ¿cómo se consiguen? En este caso se usan filtros globales que se colocan a voluntad delante del sensor en caso necesario.

Una de las cámaras de la NH posee filtros en las longitudes de onda del azul (400-550 nm), rojo (540-700 nm), infrarrojo cercano (780-975 nm) y metano (860-910 nm). Este último es muy interesante, pues está calibrado para las longitudes de onda en la que emite principalmente el metano. Sólo hace falta colocar el filtro delante del sensor tomar una sola foto así y la imagen nos dirá en dónde el metano es abundante.

Este filtro de metano no se suele usar para obtener imágenes a color adaptadas a la visión humana. Para ello se utilizan los otros tres filtros con los que se obtienen tres imágenes distintas del mismo objetivo que deben ser procesadas para adaptarlas a la visión humana y crear una sola imagen a color. El resultado se aproxima mucho a una imagen en color normal que tomaría una cámara estándar.

Las imágenes a color que vamos a discutir aquí han sido obtenidas así, pero los chicos de la NASA han saturado un poco los colores para que estos se aprecien mejor. Además, como la resolución de cada imagen es más bien reducida en comparación con las imágenes de la cámara réflex que tenemos en casa, los técnicos de la NASA construyen un mosaico a partir de varias fotos individuales para alcanzar una imagen con una resolución brutal.

Además, el detalle de la foto se consigue en blanco y negro con una cámara en alta resolución y la información en color con otra cámara de menor resolución dotada con los filtros. Estas dos imágenes se pueden combinar en una.

Sí, pero, oiga usted, ¿no entiendo por qué tenemos que esperar un año para tener todas las fotos que NH tomó en su día si ahora cualquier puede ver estas imágenes en su casa en una fracción de segundo al conectarse al servidor web de la NASA?

Bueno, las imágenes que usted ve aquí en NeoFronteras o en el servidor de la NASA no son imágenes completas, sino imágenes comprimidas que han perdido parte de la información que contenían y que, gracias al uso de diversas técnicas algorítmicas, no quedan del todo mal (sobre todo si no se comprimen mucho). Esto les permite alojarse en un servidor web y transmitirse rápidamente (incluso en el servidor de NeoFronteras en Texas).

Al ojo humano esta pérdida de calidad no le importa, pero al científico esto sí le importa y trabaja con imágenes completas sin comprimir que pesan mucho, precisamente las imágenes que recibe de NH en este caso. Sin embargo, las primeras fotos del encuentro cercano se enviaron desde la NH ya comprimidas para tener pronto imágenes del planeta enano, aunque no fueran de mucha calidad.

El ancho de banda (es decir, la capacidad de transmitir información) que tenemos ahora en nuestros hogares puede ser muy alta. En el caso de la fibra óptica se puede llegar a los 100 o 300 Megabits por segundo.

La conexión de fibra que tiene el ordenador que uso ahora mismo para escribir estas líneas llega a los 50 Mbits pico de bajada y a los 5 de subida, aunque el cuello de botella está en la tarjeta ethernet que usa el ordenador. Si se tiene ADSL la velocidad es mucho menor. Y si se usa un modem, una de estas imágenes de Plutón en png descargada de la web de la NASA puede demorarse minutos.

La sonda NH está al borde del Sistema Solar, a 5000 millones de km de la Tierra, y transmite con una potencia de 2,1 vatios en promedio a través de una pequeña antena parabólica (de 2 metros de ancho) usando ondas de radio polarizadas en la banda X. La señal tarda casi 5 horas en llegar a nuestro planeta y se recibe alternativamente según la Tierra gira en 3 radioantenas de 70 m de diámetro situadas estratégicamente en distintas partes del mundo (EEUU, España y Australia). Al final se consigue un ancho de banda de sólo 1kbit/s aproximadamente.

Ni siquiera se recibe información neta, sino que se usa un sistema redundante de envío de información para que no se pierda ni un píxel de la imagen, aunque sea a costa de saturar aún más el estrecho ancho de banda.

Debido a todo esto, los varios Gigas de información que la NH tomó en su día nos tardarán en llegar un año a la Tierra.

Todo lo anterior nos sirve para apreciar mejor el logro que significa el recibir estas imágenes de Plutón. Logro que se ha conseguido gracias al desarrollo científico y tecnológico de los últimos 50 años.

Si usted con su smartphone, amigo lector, puede enviar orgulloso la foto de su hija a su primo que vive en otro continente en un segundo es gracias, entre otras cosas, a este tipo de tecnologías desarrolladas para la exploración espacial.

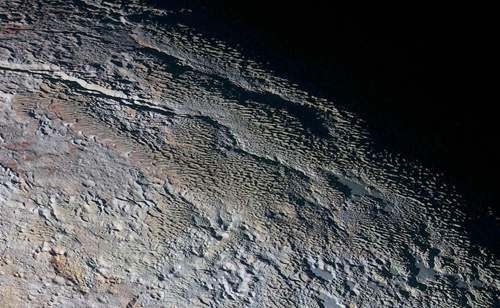

Si pasamos ahora a la última remesa de fotos enviadas por NH podemos apreciar, de nuevo, accidentes geográficos que no tienen, de momento, una buena explicación. El terreno más asombroso en este sentido puede ser la región que se ha denominado de “piel de serpiente” (hacer clic en la imagen para ampliar):

[1] [1]

|

En esta imagen se aprecian detalles que no se habían visto antes. La luz rasante permite distinguir muy bien la textura del lugar, con un paisaje arrugado que ha dejado atónitos a los miembros de la misión. Según William McKinnon “se parece más a la corteza de un árbol o a las escamas de un dragón que a un accidente geológico. Esto tomará su tiempo desentrañarlo, pero puede ser una combinación de fuerzas tectónicas internas y la sublimación del hielo producida por la débil luz que recibe Plutón”.

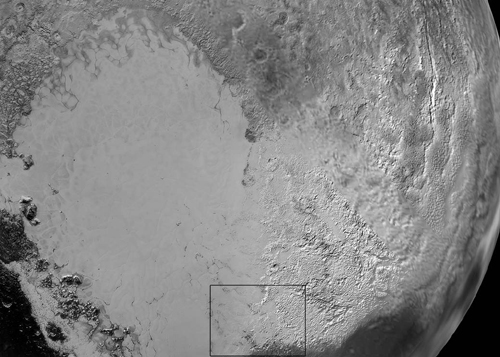

Algo similar se puede decir de la textura de algunas regiones de Sputnik Planum que ya vimos anteriormente (hacer clic en la imagen para ampliar):

[2] [2]

|

Imagen en la que se puede apreciar cierta textura sobre un terreno que antes creíamos completamente llano. La resolución, de 270 metros en este caso, desvela lo que podrían ser dunas o accidentes geográficos producidos por la sublimación del hielo de nitrógeno. En el mosaico completo [3] se puede ver cómo las montañas están recubiertas por materiales rojizos, presumiblemente hidrocarburos. El hielo de nitrógeno fluiría desde estas montañas de hielo de agua en forma de glaciares de hielo de nitrógeno hasta la depresión que sería Sputnik Planum. Sobre ella, además de la mencionada textura, se aprecian cambios en la coloración superficial y fronteras entre lo que podríamos llamar estructuras polígonales.

Si queremos apreciar otras texturas novedosas nada como contemplar esta imagen de “El corazón” de Plutón, aunque sea en blanco y negro (hacer clic en la imagen para ampliar):

[4] [4]

|

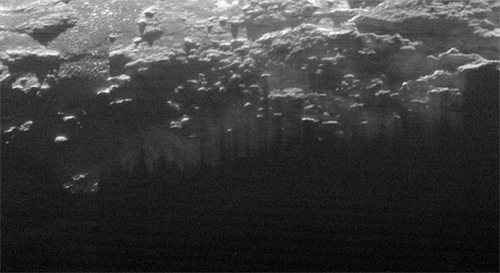

En esta otra imagen en blanco y negro se puede apreciar la neblina superficial que se produce sobre Plutón. La imagen fue tomada al cabo de 15 minutos después de la máxima aproximación en la región limítrofe entre el día y la noche plutoninos:

|

Nos habla de un mundo bonito y menos inerte de lo que cabría pensar. Un mundo en donde hay nieblas matutinas producidas por la luz de un Sol muy muy lejano.

Para terminar veamos una imagen de Plutón al completo en color realzado que nos dice que este mundo tiene partes rojizas posiblemente recubiertas por hidrocarburos, pero también partes azules (hacer clic en la imagen para ampliar):

[5] [5]

|

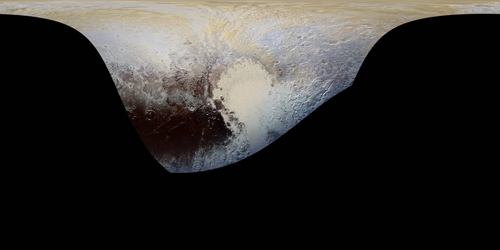

La imagen de cabecera corresponde a la proyección cilíndrica de Plutón construida a partir de las fotos en color tomadas por NH. La región en negro corresponde a partes no fotografiadas en detalle (la mayoría de su superficie). Esa parte en negro es equivalente a las regiones del mapa de África que estaban en blanco antes de ser exploradas en el siglo XIX. Estas nuevas tierras ignotas no las podremos conocer en muchas décadas y no podremos aterrizar (¿aplutonizar?) sobre ellas con la actual tecnología.

Copyleft: atribuir con enlace a http://neofronteras.com/?p=4771 [6]

Fuentes y referencias:

Web de la NASA. [7]

Fotos: NASA/JHUAPL/SWRI, Wikipedia.