Limitaciones de la IA

Una serie de experimentos y resultados matemáticos señalan los límites de la inteligencia artificial basada en redes de aprendizaje profundo.

|

El asunto de la la inteligencia artificial es algo que, desde los años cincuenta del pasado siglo, aparece súbitamente de vez en cuando y luego entra en crisis.

Cada vez resurge o resucita envuelta o basada en un nuevo paradigma. Ahora es el caso de las redes neuronales de aprendizaje profundo que corren en computadores convencionales.

El modelo actual fue propuesto ya en los años ochenta del pasado siglo, pero entonces se carecía de suficiente poder de procesamiento. Ahora se han efectuado algunas mejoras, como la introducción aleatoriedad. A veces incluso se fuerza a dos redes a competir entre sí o a aprender una de la otra.

Estas redes consisten en varias capas de «neuronas» interconectadas entre sí. El estímulo externo se introduce en la primera capa en donde es procesada y la salida pasa a la segunda y así sucesivamente. A mas capas, más profundidad y mejor comportamiento, pero se exige mayor poder computacional. Estas neuronas pueden tener varios estados y sus conexiones con otras se pueden ver reforzadas o debilitadas en función de cierto aprendizaje.

Son entrenadas con estímulos específicos y producen ciertas salidas. Cuando la salida es correcta se refuerza ese comportamiento y al contrario si es incorrecta. Al final del periodo de entrenamiento la red neuronal debe de haber aprendido a realizar una tarea, como el reconocimiento de ciertas formas, una tarea que es casi imposible de realizar por programas convencionales. Pero funciona como una caja negra, no se sabe qué ocurre dentro, simplemente funcionan.

No están libre de pegas, pues, entre otras cosas, presentan problemas de sobreaprendizaje. En algún momento hay que dejar que la red deje de aprender o terminará haciendo mal su trabajo. La red neuronal de aprendizaje profundo se proporciona ya aprendida y no se suele dejar abierta para que siga aprendiendo. El ejemplo paradigmático es el de la conducción de vehículos. Si dejamos que aprenda, y el conductor habitual es un mal conductor o toma demasiados riesgos, al final la red neuronal le copiará creyendo que esa es la manera adecuada de conducir y terminará conduciendo igual de mal que su dueño. Y es que las redes neuronales no tienen criterio propio, no comprender o entienden. Como uno de los comentaristas de esta misma web dijo una vez, la IA significa a veces «Idiotez Ampliada».

Pero hay que reconocer que la IA actual hace cosas muy bien. Un ejemplo es que estas redes juegan muy bien al go o al ajedrez, superando a los maestros. Los juegos son un buen campo de experimentación para empezar a usar cualquier IA, porque tienen reglas limitadas y pocos grados de libertad, por eso se suelen emplear. Otro ejemplo es el de la conducción de vehículos, que no lo hacen del todo mal. También encuentran exoplanetas entre los datos de tránsitos sobre estrellas. Quizás el mayor logro en la actualidad sea la predicción del plegamiento de proteínas a partir de la secuencia de aminoácidos. El sistema de IA de Alphabet Inc (la empresa que Google creó para evitar pleitos por monopolio) es en la actualidad imbatible en esta tarea del plegamiento de proteínas frente a otros programas, pero no acierta, ni mucho menos, siempre.

Ahora, un equipo de investigadores de UCLA ha publicado los resultados de las pruebas a las que han sometido a algunas de estas redes de aprendizaje profundo. La idea era testar los límites de estos sistemas. Los resultados no son nada halagüeños con estas IA y los investigadores sostienen que aún necesitan muchos años de desarrollo para que sean realmente eficientes. Skynet se hará esperar.

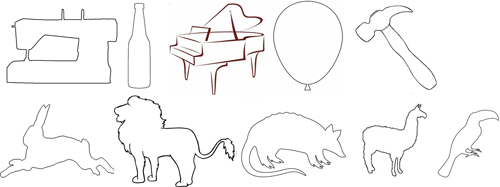

Las pruebas realizadas en cinco tipos de experimentos consistían en la identificación de objetos, pero en lugar de presentar los objetos tal cual, se camuflaban un poco. Así, por ejemplo, se presentaba una tetera con los hoyos de una pelota de golf, unos calcetines con forma de elefante o un camello con rayas de cebra. Estas tareas de reconocimiento pueden ser realizadas por cualquier humano sin problemas.

La red de aprendizaje profundo que usaron primero fue VGG-19, una de las mejores de visión artificial capaz de reconocer objetos y animales a partir de imágenes en color de ellos. VGG-19 sólo pudo reconocer bien los objetos presentados en 5 ocasiones de entre 40. Es decir, fracasó estrepitosamente.

«Las máquinas tenían severas limitaciones que necesitamos comprender», dice Philip Kellman. Añade que están diciendo que hay que esperar y que no hay que ir tan rápidos en esto de la implantación de los sistemas de IA.

«Podemos engañar a estos sistemas de una manera muy fácil. Estos mecanismos de aprendizaje son mucho menos sofisticados que la mente humana», añade Hongjing Lu, otro miembro del equipo de investigadores.

Para el caso del elefante el porcentaje de aciertos fue del 0%, mientras que para la tetera fue del 0,41%, pues su primera propuesta casi siempre era de que se trataba de una pelota de golf. El sistema de aprendizaje se veía engañado por la textura de la imágenes y no fijaba en la forma global, mientras que para la mente humana lo más importate es la forma, no los detalles.

|

En otro experimento mostraron figuras de cristal tanto a VGG-19, como a otra red neuronal denominada AlexNet y bajo el mismos sistema de aprendizaje y base de datos de imágenes. Ambas lo hicieron bastante mal.

|

En un tercer experimento se mostraba a ambos sistemas dibujos de imágenes en forma de contorno en negro sobre fondo blanco. La idea era ver lo buenos que eran a la hora de reconocer formas y no texturas. Los resultados también fueron desastrosos para ambos sistemas. No lograban distinguir una mariposa, un avión o un plátano.

|

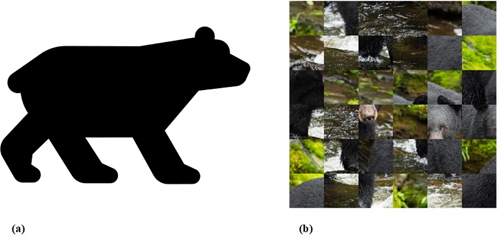

En el cuarto experimento se mostró 40 imágenes a reconocer como siluetas en negro sobre fondo blanco. En este caso tuvieron más éxito, con un 50% de aciertos. Pero el éxito para cada caso en particular dependía de la red neuronal usada. Una tenía más éxito que la otra en varios casos, pero no había una ganadora global. Creen que este «éxito» relativo se debe a que las redes funcionan mejor cuando no hay «contornos internos», bordes de la imagen observada que les confunden.

|

En el quinto experimento los investigadores alteraron las imágenes normales para formar un mosaico aleatorio y así hacer que fuera más difícil su reconocimiento, pero no tanto como para que fueran irreconocibles por humanos, primando así la textura. En este caso VGG-19 reconoció 5 de 6, por lo que se puede decir que en este caso sí tuvo éxito.

Además, para poder comparar los resultados obtenidos, los investigadores tomaron imágenes en silueta negras y se las mostraron a estudiantes voluntarios durante un segundo. Las reconocieron en un 92% de las ocasiones. Cuando esas misma imágenes se alteraban en forma de mosaico, entonces acertaban en un 23% de las ocasiones. Cuando se les daba más tiempo los porcentajes subían a un 97% y un 37% respectivamente.

Los humanos ven los objetos de forma completa, mientras que las IA sólo identifican fragmentos de esos objetos, no ven su forma completa.

Según afirman los investigadores, sus conclusiones se aplican de igual manera a otras redes de aprendizaje profundo.

No deja de ser curioso que este tipo de resultados resulten obvios para cualquier filósofo. Aunque es verdad que en este caso se usa el método científico.

|

Otros investigadores van más allá y afirman que la cuestión del aprendizaje en el que un algoritmo es capaz de extraer, o no, un patrón de un conjunto de datos limitado está ligada a una paradoja lógica que Kurt Gödel expuso en los años treinta del pasado siglo: la hipótesis del continuo. Esta hipótesis fue propuesta en su día por Cantor, pero permaneció sin resolver hasta la llegada de Gödel.

Según Gödel, el que haya o no infinitos conjuntos transfinitos entre el conjunto de los números naturales y el conjunto de los números reales es una cuestión indecidible al caer dentro del teorema de indecibilidad que el propio Gödel enunció. Simplemente no se puede decir si eso es falso o verdadero. Se elige un caso de ellos y se tiene una matemática distinta. Básicamente existen dos universos matemáticos paralelos correctos. Uno en el que la la hipótesis del continuo es correcta y otro en la que no.

Esto es generalizable para cualquier otra afirmación indecidible (hay muchas), por lo que hay muchos de estos «universos» matemáticos, todos ellos correctos y autoconsistentes. Los teoremas de incompletitud de Gödel supusieron el fin del sueño de Hilbert de una Matemática (¿platónica?) perfecta y constituyen uno de los mayores logros intelectuales del siglo XX. Siempre habrá enunciados que no se podrá demostrar si son verdaderos o falsos. Se pueden incorporar como axiomas (verdaderos) a uno de esos universos, lo que, a su vez, hará que aparezcan otras afirmaciones indecibles dentro de esos universos y así por siempre. Este resultado es algo que a algunos nos asombró sobre manera, cuando lo leímos hace ya más de 35 años.

Esta indecibilidad tiene también implicaciones en ciencias de la computación. Ya en su día, Alan Turing demostró que para determinadas clases de preguntas, como si un algoritmo se detendrá o no, no se puede garantizar que se alcance una respuesta en un número finito de pasos.

Los investigadores que se encontraron con este resultado de indecibilidad de la hipótesis del continuo aplicado al aprendizaje se muestran sorprendidos, pues no esperaban que este tipo de fenómeno apareciera en un problema supuestamente simple y lejano como un sistema de aprendizaje. Pero, obviamente, tiene implicaciones fundacionales tanto en Matemáticas como en Inteligencia Artificial. Básicamente impone un límite al conocimiento (otra vez).

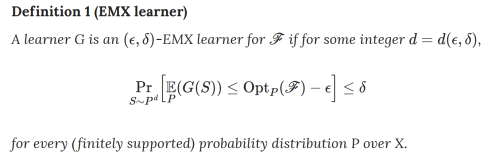

Amir Yehudayoff (Instituto Tecnológico Israelí en Haifa) y su colaboradores llegaron a este resultado cuando estudiaban el aprendizaje y la compresión de datos, lo que les llevó la Teoría de Conjuntos y finalmente a la hipótesis del continuo. En este caso, el resultado no se aplica directamente a redes neuronales de aprendizaje profundo, sino que el aprendizaje que definen es más general y abstracto.

El resultado está construido sobre un sistema muy simple en el que un algoritmo tiene que responder con un sí o con un no a la pregunta de si una determinada imagen mostrada, dentro de un conjunto limitado de posibles objetos, corresponde a un gato, por ejemplo.

En su artículo muestran que si la hipótesis del continuo es cierta, entonces una muestra pequeña es suficiente para hacer una extrapolación. Pero si es falsa, ninguna muestra finita es suficientemente grande. De este modo, llegan a demostrar que el problema del aprendizaje (definido de una determinada manera) es equivalente a la hipótesis antes mencionada y, por tanto, el problema del aprendizaje está también en un estado tal que puede ser resuelto sólo mediante la elección de un universo axiomático concreto.

¡Toma ya!

Copyleft: atribuir con enlace a http://neofronteras.com

Fuentes y referencias:

Artículo original I.

Artículo original II.

Imágenes: Nicholas Baker, Hongjing Lu, Gennady Erlikhman y Philip J. Kellman

Imagen ecuación: Shai Ben-David, Pavel Hrubeš, Shay Moran, Amir Shpilka y Amir Yehudayoff.

30 Comentarios

RSS feed for comments on this post.

Lo sentimos, esta noticia está ya cerrada a comentarios.

lunes 14 enero, 2019 @ 3:51 am

La inteligencia artificial lo será mientras alguien proveea la electricidad y en tanto esta esté bajo el control de las corporaciones y no del pueblo, que es el soberano, la desigualdad y la opresión continuarán o incluso se incrementarán.

lunes 14 enero, 2019 @ 2:41 pm

Desde el sur:

¿Y qué tiene que ver eso que dice con los expuesto en el post? Una cosa es que el hilo de conversación termine derivando en temas alejados y otra empezar ya así.

lunes 14 enero, 2019 @ 6:30 pm

Sí, está claro que todos los actos humanos están condicionados por su organización social. Pero el hecho de ir a la Luna (la voluntad) es independiente de la mecánica, la siderurgia, la química, la electrónica, etc. Por supuesto que la IA se usa como herramienta tecnológica, como se usaba un hacha de sílex, un catalejo o un neumático, pero las leyes de la naturaleza que necesitamos saber, e incluso las que aprendemos por contingencia en el proceso de construir estas herramientas, son eso, leyes de la naturaleza, que a diferencia de las nuestras duran bastante más en el tiempo, son definitivamente inapelables y no es posible mangonearlas.

Dicho todo lo cual, no sé si entendí bien el trasfondo último de todo esto. Por un lado, me he quedado bastante pegado porque la conexión con la paradoja de Chomsky es evidente: poder saber tanto a partir de tan pocos datos al tiempo que una avalancha de estos no nos permite ver auroras boreales en principio más obvias. Pero, entonces, en la versión «fuerte» del postulado, el auténtico aprendizaje requiere, si no de consciencia, sí de un nivel de abstracción que desde luego está totalmente fuera del alcance de un algoritmo, la versión «débil» ya la sabíamos, en realidad estos sistemas no aprenden, simplemente solidifican un sistema de ensayo-error (extremadamente frágil) a modo de ordenador analógico, que es muy dependiente de unas condiciones concretas para ser útil (que no para funcionar).

Vamos, que Minsky ha tenido el detalle poco caballeresco de palmarla (en 2016) cuando parece que va a recibir un megazasca de base matemática palmaria de esos que tanto resuenan en la ciencia. Supongo que soy injusto con uno de los fundadores del MIT, pero bueno, son mis prejuicios y me los guiso y me los como.

martes 15 enero, 2019 @ 10:00 am

No sé si interpreto bien el final del artículo, pero pienso que toda inteligencia -digamos humana- funciona dentro de uno u otro sistema axiomático y el salirse de él, cambia los paradigmas.

jueves 17 enero, 2019 @ 1:33 am

¿Se sabe qué puntuación ELO´tendría el ajedrecista autómata de Torres Quevedo?

jueves 17 enero, 2019 @ 5:38 pm

El principio de Incertidumbre de Heisenberg y los teoremas de incompletitud de Gödel parecen ser unos límites infranqueables para el progreso del conocimiento humano. Eso es lo que se suele decir y muy probablemente sea así. Pero uno se pregunta si estos límites son imposiciones de la naturaleza o por el contrario son límites a nuestra inteligencia humana, es decir si nuestras mentes son incapaces de ir más allá en el conocimiento. Particularmente me resulta desagradable pensar que hay límites a nuestro conocimiento.

viernes 18 enero, 2019 @ 2:15 am

Depende del enfoque que uses, querido amigo Lluís. Desde el enfoque del realismo ontológico, que es el que más me convence, serían leyes de la naturaleza. La incertidumbre no sería producto de las limitaciones de nuestro cerebro, sino que otras hipotéticas civilizaciones E.T. (más avanzadas que la nuestra), se encontrarían con el mismo obstáculo.

Otro puñado de abrazos.

viernes 18 enero, 2019 @ 9:49 am

En efecto, Miguel y Lluís. La naturaleza, la realidad, independiente de si soy un humano que piensa en ella o ni la mira, está ahí y es como quiera que sea. Por nuestra parte intentamos conocerla con nuestros medios basados en la estructura de nuestro cerebro. Pero él mismo forma parte de la naturaleza. Entonces ¿será que esas limitaciones son propias de este trocito de naturaleza que es nuestro cerebro? ¿Conoce el delfín las leyes de la gravedad? ¿Tiene alguna forma de conocimiento de ella totalmente ajena a la nuestra? ¿Tan ajena que no nos es posible ni imaginarla?

viernes 18 enero, 2019 @ 8:59 pm

Por partes:

El ajedrecista de Torres Quevedo, si me estoy refiriendo al mismo autómata (no conozco otro de él para estas lides) está en una especie de museo del Colegio de ingenieros de PCyC en Madrid, creo que funciona perfectamente, pero sólo juega una final de rey torre contra rey, siempre gana como debe ser.

El principio de incertidumbre en mi opinión es una estructura constitucional del universo, si se le quiere llamar límite no me opongo, pero en realidad lo que es ficticio es nuestra construcción biocultural de la realidad como bolas de billar mondas y lirondas o plastas indefinidamente particionables, como mantecas o emulsiones de discontinuos y continuos ad hoc. No veo que acote con más limitaciones al conocimiento de lo que pueda hacerlo c, cosa que a día de hoy no preocupa a nadie.

Respecto a Gödel, el tema ya es más peliagudo. La relación última entre las matemáticas y la realidad impone respeto, cuasi religioso, y desde luego pensamos que no todas las construcciones matemáticas posibles tienen por qué existir en el mundo real, yo desde luego la mano en el fuego no la pongo, lo que nos lleva a espinosos temas taumatúrgicos (tal cual). Gödel pone límites a las matemáticas mismas, pero hasta ahora no hemos encontrado ninguna indecibilidad (en el sentido de imposibilidad de afirmar o refutar) en ninguna descripción matemática de la realidad, mucho me temo que antes o después sí aparecerá tal cosa y aunque la naturaleza es educada y siempre responde a nuestras preguntas («experimentos»), es muy posible que algunas respuestas escapen a este protocolo.

Sí, el delfín conoce la ley de la gravedad, su cuerpo y hasta su consciencia la conocen bien puesto que existen en su seno. Creo que la pregunta es si entienden la ley de la gravedad, y en eso aunque les llevamos una cierta ventaja, no parece que sea tanta a fin de cuentas.

En cuanto a los axiomas… que son dogmas de fe con la inmensa diferencia que siendo igualmente instrumentales no presentan tantos problemas a la hora de ser desechados, me quedo con una de las reflexiones anacrónicas de Eco en esa novela tan interesante que le salió llamada «El nombre de la rosa», donde desfilan citas anacrónicas de filósofos y científicos en un escenario de crímenes en una abadía medieval. El personaje principal, el investigador (franciscano) remedo de Sherlock Holmes pero con continuos guiños bastante zafios a Occkham, a través de sus métodos empíricos reconstruye correctamente de forma forense cómo fue cada uno de los crímenes (y por qué) y se hace un cuadro bastante certero de por qué están teniendo lugar (por la posesión de un libro de la biblioteca), sin embargo su visión del mundo le hace patinar a la hora de hacer la valoración última y final, la más importante obviamente, atribuyendo a malicia lo que se trata de contingencia bajo la forma de profecía autocumplida. Eso al final hace que la cosa termine no muy bien, por no decir fatal, y en una de las reflexiones finales (creo que de Wittgenstein) viene a decir que la ciencia construye escaleras para subir a niveles cada vez más altos que nos permiten tener cada vez una visión más amplia e inimaginada, pero esas escaleras una vez cumplida su función deben ser desechadas para construir las siguientes para continuar ascendiendo.

Y si esto es universal o antropológico, en el sentido de antropopiteco (principio), eso no tenemos ni pajolera idea, y hasta puede ser divertido preguntarle a una Idiotez Artificial. Algo de tontería de oráculo siempre ha volado por encima de esto, que debe ser que el propio cerebro se ofusca sólo y luego se percata, aunque a saber si lo hace aposta.

domingo 20 enero, 2019 @ 9:40 am

Si nos centramos en el terreno de la Biología, parece que se cumple lo que apuntas de que no toda matemática es posible, estupendo Dr. Thriller: lo que hay es poca matemática que se cumple invariablemente (campana de Gauss, sucesión de Fibonacci, «phi», fractales y… casi acabamos).

domingo 20 enero, 2019 @ 5:55 pm

Las limitaciones mencionadas no son producto nuestro, sino que son inherentes a la Naturaleza o incluso, como el teorema de Gödel, inherentes a toda realidad física sujeta a las Matemáticas.

domingo 20 enero, 2019 @ 5:58 pm

Dr.Thriller:

Hay varios ejemplos de enunciados indecidibles, como la hipótesis del continuo. Se puede admitir que es falso y se crea unas matemática válida (consistente). O se admite que es verdadero y se crean otras matemática igualmente válida (consistente). A cada una, a su vez, le habrán aparecido otros enunciados, que no existían antes que también serán indecidibles.

domingo 20 enero, 2019 @ 6:46 pm

Hay una fuerte conexión entre computación y matemáticas. En informática se trabaja con algoritmos, que no son más que recetas de cálculo. Y un algoritmo puede ser la demostración de un teorema por un matemático, por ejemplo. De hecho, se llegó a proponer en su día algoritmizar las matemáticas de tal modo que se pudieran demostrar de manera automática todos los teoremas posibles. Y un teorema no es más que un enunciado sobre el cual se ha podido demostrar que es verdad.

Hay tantos algoritmos como números naturales, por lo que hay números reales que no pueden ser calculados en tiempo finito por un algoritmo. Como hay más reales que algoritmos, entonces, existen verdades matemáticas que no se pueden demostrar porque existen más verdades que números naturales y por tanto que algoritmos de demostración. Hay más cosas que decidir que cosas capaces de decidir y en ambos casos hacen un número infinito. Esto se sabe desde los resultados de Gödel y Turing.

domingo 20 enero, 2019 @ 6:49 pm

En este caso que se menciona en el post se trata el problema del aprendizaje. En general, el problema del aprendizaje consiste en si dado un problema y unos datos suministrados se puede aprender o no a resolverlo. En este caso se ha construido un modelo de aprendizaje relativamente complicado (aunque según los autores conceptualmente sencillo), que es el que se muestra en la última imagen, que trabaja con conjuntos infinitos.

Han podido demostrar que para este modelo hay un nuevo caso de indecibilidad. No se puede decidir si con cierta cantidad de datos de entrada se puede aprender o no cierta propiedad en forma de una función lógica. Hay problemas sobre los que no se puede demostrar que se pueda aprender. Pues es lo mismo decir que no se puede aprender que decir que no se sabe si existe o no un algoritmo capaz de decidir si tiene solución (indecibilidad). No se trata de que el sistema falle o acierte a la hora de aprender, sino que no se puede demostrar que lo va a hacer o no.

En el fondo es lo mismo que ya se sabía para otros casos, como la hipótesis del continuo (que ya se demostró en su día su indecibilidad), pero aplicado al problema del aprendizaje.

Es un límite teórico absoluto que no dependería de la capacidad de un computador, incluso aunque sea capaz de usar conjuntos infinitos de datos. Pero el resultado es un resultado teórico sin muchas aplicaciones prácticas en todo caso y, en particular, casi ninguna si tenemos en cuenta el tipo de modelo de aprendizaje que se definen, que es muy particular. El conjunto de datos de partida es infinito, pero tanto los humanos como los computadores reales aprenden a partir de conjuntos finitos.

Extender un resultado matemático basado en ciertas premisas a otras situaciones basadas en otras premisas distintas es muy arriesgado, por no decir que es una estrategia equivocada. Pero, si una máquina de aprendizaje basada en conjuntos infinitos de datos de entrada tiene limitaciones, ¿qué limitaciones tendrá los computadores normales o nosotros mismos que aprendemos a partir de conjuntos finitos de datos?

martes 22 enero, 2019 @ 5:31 pm

El problema, para mí, es de ignorancia (mía). Ignoro hasta qué punto la HC es algo crítico para este o aquel modelo de la realidad, y por supuesto, desde la osadía de la ignorancia, uno puede aventurar que dos modelos consistentes basados en axiomas incompatibles e indedicibles, pueden resultar igual de válidos para la descripción buscada, o uno de ellos ser más preciso que el otro al cotejarse con la realidad (y esto no tiene por qué significar nada respecto a las bases axiomáticas). Se suele decir que el universo es finito pero ilimitado, en realidad está limitado y perfectamente limitado, el problema es que esos límites no son los que nuestra mente reconoce como tales cuando inventó esa palabra (latina). Un límite inabarcable es un límite, para nosotros como si no lo fuera.

Entrando de lleno en el charco, que sepamos no existe nada infinito en el mundo real, o al menos no lo tenemos aún desnudo ante nuestros ojos. Por tanto las matemáticas desarrollan mundos de los cuales la realidad se comporta (o parece comportarse) como una parte de ellos, pero no pueden aceptarse como descripciones porque implicarían fugarse de la realidad de alguna manera. Esta aparente paradoja es bastante molesta y desde luego bien podría ser alguna indecibilidad, muchos filósofos de la ciencia han tratado de buscar apoyos a la idea de que las matemáticas son algo en parte mayor o menor fruto de la forma cómo percibimos y sentimos la realidad, es decir, para entendernos, una ET tendría unas matemáticas muy distintas a las nuestras, no hay duda de que si esto fuese así sería la revolución con R de toda nuestra historia, pero todos los indicios, toda la intuición, la consistencia de las matemáticas en el tiempo y en la historia, las pruebas adicionales de que otros cerebros no humanos en este planeta las barruntan, y otros sistemas biológicos desarrollan computaciones analógicas sobre las bases, y etc.etc., me temo que van consistentemente en la dirección de que ni siquiera la forma que tenemos de representarlas es particularmente nuestra más allá de que reaccionamos a la realidad de un modo similar a cuando generamos construcciones sensoriales (en general incompletas pero no falsas).

En suma, sigo sin atreverme a sacar conclusiones respecto a esto. Ni conclusiones, ni siquiera aproximaciones al fenómeno. Para todo lo demás, al 100% de acuerdo.

martes 22 enero, 2019 @ 5:49 pm

Por cierto, por aquello de que me explico como la HC, obviamente estoy de acuerdo en que es un problema de indecibilidad el que estamos tratando aquí en concreto, una vez bajado de mi nube atalaya (total el horizonte también limita), y con ser una información valiosísima y que acota un problema hasta ahora sin formas reconocibles, de alguna manera nos habla del molde pero no del pastel. Digamos que creo entender lo que viene siendo la indecibilidad a la hora de construir modelos matemáticos pero no me atrevo a sacar conclusiones de lo que eso pueda (o no pueda) querer decir de la realidad que describe. Si es que dice algo.

En este aspecto la MC es mucho más tratable, además es irrelevante si se «entiende» o no, funciona (o no) y punto. Lo de Gödel, como intenté explicarme, es demasiada incerteza (que no incertidumbre). Es tentador decir que es «real», además no hace falta ir a la HC, las lenguas humanas naturales tienen estructuras que posiblemente sean indecibilidades de Gödel (a fin de cuentas son un sistema formal), y son objetos reales. O no tanto. Una historia humana (o una sinfonía) son reales desde luego en su capa física «dura» (papel, tinta, distribución), pero la información que llevan codificada, que es la que presenta las indecibilidades…

No sé, me cortocircuito.

viernes 25 enero, 2019 @ 10:03 am

Llevo bastantes días sin comentar porque hice un largo escrito, se borró, lo rehíce y volvió a borrarse, así que me molesté tanto, que, junto con otras lamentaciones que no vienen a cuento, me escondí y no me he levantado un poco animoso hasta hoy.

Mis comentarios no iban de esto, pero, querido Neo, como llevo bastante tiempo intentando saber si eso a lo que he llamado conjetura -lo de que cualquier par es puede descomponerse en diferencia de dos primos-, lo es, o resulta una tontería descomunal, si puede ser consecuencia de la de Goldbach, o es tan elemental que cualquier indocumentado lo sabría, o ya está pensado y desechado. En fin, algo que me saque de este laberinto.

Gracias anticipadas lo tengas a bien o no.

lunes 28 enero, 2019 @ 5:29 am

Es un chiste esta inteligencia artificial. Si afirmamos que el cerebro es un ordenador, entonces ¿como podemos a pensar que existe la limitación dada por la hipótesis del continuo?. Si fuera real dicha limitación no podrías identificar todas formas propuestas a la IA. Es ridículo. Evidentemente lo que se dice «uno de los mayores logros del siglo XX» de ninguna manera lo es, nunca vi premiar a alguien por ver un problema y dar una solución. La hipótesis del continuo manifiesta una incongruencia entre teorías matemática sin lugar a dudas. Mientras sigamos dando tanta importancia a matemáticos, que de la realidad nada entienden, seguiremos con estos problemas.

lunes 28 enero, 2019 @ 5:31 pm

Eh… Hombre, Gödel un poco en su burbuja sí estaba, pero Euler p.ej. la realidad la veía mejor que un número bastante elevado de congéneres, y además la enganchaba con las matemáticas pero que muy bien. Yo lo que decía es que las matemáticas son «más ilimitadas» que la realidad, eso ya de por sí sí que es una paradoja y como diría un buen malo de película, bastante perturbadora. Gente con percepciones variadas de la realidad los hay a patadas, incluyendo el famoso protoquímico sueco que metía todo en la boca a ver a qué sabía (vale, todo, todo, no) y en una de estas, pues eso. También Plinio la palmó por lo visto por arrimarse mucho al Vesubio durante la recalificación urbanística de Pompeya y Herculano, cosas de gases tóxicos, unos dicen que intentando rescatar a personal y otros que la curiosidad a veces es peliaguda (nótese que no son hipótesis incompatibles). Eso sí, todos tienen muchas cosas nombradas en su honor (erupciones plinianas).

Pues Tomás, yo es que tampoco lo tengo claro para responderte. Eso sí, puedo incrementar tu confusión comentándote una parida poco conocida, todo el mundo sabe que la letra hebrea alef se utiliza para la nomenclatura de los conjuntos transfinitos de Cantor (alef cero, alef uno, etc.), lo que es menos conocido es que beth se usa para el conjunto potencia de alef cero, y beth sub uno es la cardinalidad del continuo. Pues a cuento cuento no viene, pero traído por los pelos… igual sí. Pero con Gimel ya tenemos las lamentaciones de Jeremías.

Para evitar lo de los borrados, una opción es escribir en el bloc de notas y luego hacer un copiapega. A mí me ha pasado muchas veces (y sigo pasando del bloc de notas), y creo que (en *mi* caso) ha sido para bien, así que el mecanismo tiene su función de utilidad al menos con las verborreas plinianas (y gödélicas) y se podría aceptar para este bien superior pequeños daños menores (o no tan pequeños).

martes 29 enero, 2019 @ 10:22 am

Neo no me hace ni caso en relación con mi 17. Esperaba que, al menos, me dijese que no quería saber nada. Pero no. Debe estar enfadado conmigo. por lo que dije de la TV. Era broma y espero lo comprenda.

Te agradezco la mención, Dr., así, como de pasada. Es que debo tener una mentalidad obsesiva porque no hago más que darle vueltas sin poder salir de ello, y me produce sufrimiento al darse la mano con otros problemas que, como digo, no vienen a cuento. Gracias por los consejos.

martes 29 enero, 2019 @ 7:03 pm

U ocupado.

Pero tampoco entiendo tu obsesión. No parece un problema urgente para ya, como la independència de Catalunya, mira el Breshi con qué calma se lo toman. Y se recrean. A 60 días del muro. Buñuel debió de haber hecho una película de muros y prisas.

martes 29 enero, 2019 @ 11:59 pm

Estimado Tomás:

Me da una pereza muy grande tener que contestar ese tipo de preguntas porque se parece mucho a mi trabajo y este bastante tiempo que quita ya.

Lo que comenta se parece a la conjetura de Goldbach. Quizás haya una manera de hacer que sean equivalentes. Sin embargo, hay una conjetura que se parece bastante:

https://www.microsiervos.com/archivo/juegos-y-diversion/conjetura-primos-gemelos.html

El problema de las conjeturas de teoría de números es que se enuncian muy fácilmente, pero son extremadamente difíciles de demostrar. Algunas veces se han necesitado siglos y su demostración es el producto de grandes programas de investigación a largo plazo en el que trabajan muchos matemáticos de los cuales muchos no ven el final, pero hacen avanzar la Matemáticas. Este tipo de conjeturas no son importantes en sí, sino que su importancia viene del desarrollo de Matemáticas que se necesita. Se estima que, por ejemplo, la hipótesis de Riemann se resuelva en el siglo XXII.

Generalmente no hay magia, ni idea feliz que las solucione, sino que son un resultado de un esfuerzo colectivo. Que uno, en plan francotirador, se dedique a ello es la garantía de obtener boletos para volverse loco. O, a veces, ya se está un poco de entrada: https://es.wikipedia.org/wiki/Grigori_Perelm%C3%A1n

En cuanto a los comentarios borrados no son producidos por el sistema, sino por el navegador. Esta web tiene un filtro de palabras, pero suelo rescatar aquellos comentarios que son cazados por él al cabo de un tiempo y que son normales y realizados por los habituales. A Dr.Thriller le pasa mucho debido el uso de palabrotas, pero siempre los he rescatado.

miércoles 30 enero, 2019 @ 2:43 am

Mediando sobre el plastazo del trabajo, la lástima es que me queda hasta 2.035 o 37 (fechas ya del Gran Colapso). En muchos escenarios posibles se va al garate mi sueño de jubilado, en Canarias u otra isla tropical, y dedicándome al Hedonismo en su versión más purista.

miércoles 30 enero, 2019 @ 11:58 am

Muy amable y no sabes cuanto te agradezco, querido Neo tus palabras. Es que, a veces, parece que estás a un ápice de la demostración y luego todo se va a freír espárragos, como se dice por mis lares. Me esforzaré para olvidarme del tema. Bueno, lo olvidaré, sin más. Porque tienes toda la razón. Además he sido muy egoísta al pedirte ayuda cuando tanto te esfuerzas.

Recibe un fuerte abrazo de quien tanto te admira.

viernes 1 febrero, 2019 @ 12:14 pm

Amigo Tomas.

Por si te sirve de ayuda para demostrar tu conjetura, sobre los números primos.

Te adelanto de que es solo intuición, no se si es correcta, pues no alcanzo a elaborar matemáticamente su demostración.

Imagina, de forma gráfica, el conjunto de los números positivos pares, como un conjunto infinito, en el que el intervalo entre cualquier par de números pares consecutivos es constante, este, gráficamente, tendría una densidad constante en toda su extensión.

En el conjunto de los números primos, esta densidad va disminuyendo de forma abrupta a medida que avanzamos en la busca de nuevos primos.

El conjunto de los números constituidos por la diferencia positiva entre cualquier par de primos, lo considero como una “sombra” del de los Primos. Va avanzando inmediatamente atrás del último primo descubierto.

Este conjunto sombra, es mas denso que el conjunto de los primos, su mayor valor corresponde al número par, inmediatamente anterior al último primo estudiado. Este seria el último primo encontrado menos uno.

Su menor valor corresponde a la diferencia entre el último primo encontrado y su anterior.

El conjunto sombra es por tanto cerrado, (finito) tiene un principio y un final, aunque dinámico, moviéndose siempre atrás del último primo.

Entonces creo que, si el intervalo entre los dos últimos primos es suficientemente grande (lo que es posible), en el cabe el conjunto “sombra” y sobran elementos del conjunto de los pares sin cubrir.

Resumiendo, creo que pueden existir números pares que no sean la diferencia de dos primos.

Abrazos.

viernes 1 febrero, 2019 @ 3:44 pm

Tomas creo que tienes razón en tu “conjetura” al decir que cualquier número par es la diferencia de dos primos. Rectifico mi conclusión del comentario anterior.

El raciocinio que expuse, creo que es válido, pero lo he limitado únicamente al último primo estudiado. No he tenido en cuenta que este mismo concepto se aplica (retrocediendo) a todos los primos anteriores, por lo que este conjunto “sombra” al ir retrocediendo cubrirá todos los números pares anteriores al último primo estudiado.

Dos abrazos para compensar.

sábado 2 febrero, 2019 @ 11:57 am

Muchas gracias, Eduardo por tu interés. De momento descansaré en ese tema pues se había convertido en una obsesión. Quizá lo retome algún día, pero no me lo tomo como un deber; si me place, lo haré y si no, no.

Otra vez gracias y un fuerte abrazo.

lunes 4 febrero, 2019 @ 11:01 am

Se dice en el prefacio de un libro sobre los primos: «En un sentido metafórico, los números primos son como un virus maléfico que, cuando ataca la mente de un matemático, es muy difícil de erradicar. Euclides, Fermat, Euler, Gauss, Riemann, Ramanujan y una larga lista de los matemáticos de más renombre cayeron en sus redes. Algunos consiguieron zafarse…».

Muy a propósito.

lunes 4 febrero, 2019 @ 12:11 pm

Si eso les sucedió a los genios, ¿qué podemos esperar los aficionadillos?

martes 5 febrero, 2019 @ 2:12 am

Con todos esos que citas, y añadiendo a Cantor y a la lista, llegamos ya a los 30 comentarios. Apropiado para una noticia que se adentra en conceptos con tanto peso como la hipótesis del continuo y la incompletitud de Gödel.