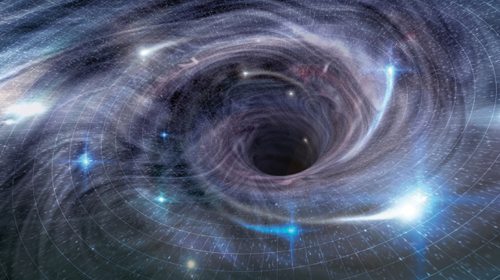

Conexiones entre la gravedad y complejidad computacional

Una nueva solución al problema del muro de fuego que se introdujo para salvar la paradoja de la información en agujeros negros termina encontrando conexiones entre gravedad y complejidad computacional.

|

En octubre pasado veíamos en NeoFronteras un resultado que causó mucho revuelo en el mundillo. Joseph Polchinski y Donald Marolf encontraron un problema agujeros muy viejos. Al parecer, un observador que caiga en un agujero negro de este tipo puede efectuar un protocolo cuántico que viole el teorema de no clonación de la física cuántica y entonces vuelve a aparecer el problema de pérdida de información en los agujeros negros, lo que viola la reversibilidad de la mecánica cuántica.

Para solucionar este problema propusieron que el espacio no es suave en las cercanías del horizonte de sucesos de un agujero negro como se había asumido hasta ahora, sino que hay una división, frontera u horizonte al que llamaron “muro de fuego”, un muro de energía que podría ser el fin del espacio-tiempo tal y como lo conocemos. Cualquier cosa que chocara contra ese muro se disolvería en sus bits de información constituyentes, así que la información se conserva al no pasar al interior. El horizonte de sucesos no puede ser cruzado y el agujero negro “tiene pelos”. Pero esto contradice la Relatividad General, ya que, según esta teoría, el cruce de horizontes de sucesos debe ser suave y no tener sobresaltos.

Algunos físicos que estudiaron en principio esta idea se resistieron a aceptarla al considerar este “muro de fuego” como demasiado extraño o artificial. Pero nadie parecía encontrar argumentos válidos en contra de su existencia sin sacrificar alguna cosa. Desde entonces han estado buscando maneras de eliminar este muro de fuego, en concreto de eliminar la necesidad de su existencia. Basta con resolver, una vez más, la paradoja de la información. Hace un tiempo publicamos en estas páginas los avances en este campo, en los que también participó Hawking. Aquellos que quieran saber en detalles sobre el problema pueden consultar esa referencia.

Nature se hace eco del último avance sobre el asunto protagonizado por Leonard Susskind. Lo interesante no es la solución en particular, sino las implicaciones que tiene en otros campos. Sean “muros de fuego”, “gatos de Schrödinger” o “cerebros de Boltzmann”, lo importante no es si existen o no, sino que su existencia teórica pone en evidencia alguna contradicción interna de nuestras teorías, lo que permite el avance en Física Teórica.

Ahora pasemos de momento a un concepto de ciencias de la computación. Los problemas computacionales pueden tener una solución rápida o no. Eso depende de su complejidad computacional. Si el sistema crece en complejidad de manera lineal con su tamaño estamos en el mejor de los casos posibles y siempre podemos resolverlo. Incluso cuando crece polinómicamente también se puede abordar con la suficiente paciencia. Pero a veces la complejidad crece exponencialmente y entonces se llega a un punto que ni con la computadora más rápida el problema puede ser resuelto. Un caso típico es el problema del viajante, que versa sobre un viajante que parte de su ciudad y vuelve a la misma visitando muchas otras ciudades en el menor tiempo posible. A partir de cierto número de ciudades el problema es simplemente inabordable por todo computador si se pretende obtener la solución exacta (siempre nos podemos conformar con una solución aproximada). Se puede decir que hay problemas que son simplemente incomputables y que marcan un límite a nuestro conocimiento. Hay muchos problemas del tipo del viajante que les pasa lo mismo.

Todo esto viene a cuento porque se ha recurrido al concepto de incomputabilidad para resolver el problema de la información y de la necesidad del muro de fuego a partir de una idea de Patrick Hayden (Universidad de Stanford). Según notó Hayden, si se aplica la teoría de la complejidad computacional al protocolo cuántico visto antes que realiza en observador en caía, se ve que es imposible realizarlo de forma práctica. Simplemente, al igual que le pasa al viajante, el número de pasos a ejecutar crece exponencialmente. Esto impide que el observador termine el protocolo antes de que el agujero negro se evapore. Por tanto no hay problema de la información y ya no hay necesidad del muro de fuego. Daniel Harlow ayudó a dar solidez al argumento y concluyó que era un principio sólido.

El argumento Harlow-Hayden ha tenido defensores y detractores, pero Susskind ha usado este argumento para llegar a la misma solución. Aplicando este argumento a agujeros negros en un espacio de anti De Sitter llega a la conclusión de que, efectivamente, el interior de un agujero negro y la información que pudiera caer en él están protegidos por un escudo de complejidad computacional que hace innecesario el muro de fuego.

Pero también ha llegado a interesantes resultados. La complejidad computacional crece en el tiempo y se comporta como un campo gravitatorio, pues un objeto que caiga a un agujero negro en ese espacio de anti De Sitter se mueve hacia regiones en donde hay mayor complejidad computacional en una especie de atracción similar a la gravedad. Esto sugiere que la gravedad podría ser un fenómeno emergente que aparecería a partir de la complejidad computacional.

Además, esto también está conectado con otro resultado que vimos también por aquí sobre entrelazamiento en agujeros de gusano. Bajo esta nueva óptica el aumento de la complejidad computacional está asociado a un alargamiento de la longitud del agujero de gusano.

Como el propio Susskind admite, la idea es especulativa y dice que no sabe adónde irá a parar todo esto. “Pero creo que esta conexiones complejidad-geometría son sólo la punta del iceberg”, añade.

Copyleft: atribuir con enlace a http://neofronteras.com/?p=4448

Fuentes y referencias:

Noticia en Nature.

Artículo en ArXiv I.

Artículo en ArXiv II.

Ilustración: SPL.

7 Comentarios

RSS feed for comments on this post.

Lo sentimos, esta noticia está ya cerrada a comentarios.

viernes 6 junio, 2014 @ 11:33 pm

Sobre estos temas tan teóricos, tan hipotéticos, parece difícil comentar, como se comprueba. Permitidme, desde una postura respetuosa con los verdaderamente enterados, aportar el punto de vista del aficionado a estos temas, sin manejarse con las sofisticadas herramientas matemáticas que ellos usan… Supongamos un par de bits de información ( en qué consisten? ), cayendo hacia su particular agujero negro… el tiempo se eterniza para ellos visto desde nuestro lado ( el péndulo de sus relojes bate eones ) , por tanto aunque tarden casi una eternidad en caer, para nosotros ya han caído en cuanto los perdemos de vista, o eso creemos. Su reloj se ralentiza al máximo, los fenómenos asociados a él también lo hacen,pero para ellos no ocurre nada absolutamente y todo sigue su marcha normal ( pueden seguir charlando como hasta el momento ). Por cierto, su charla versa, inexorablemente , sobre su incierto futuro… a punto de llegar, o eso creen.

Visto así, cerca del límite, pudiera ocurrir que los agujeros negros amontonen todo el material en su horizonte sin ser capaces de deglutir ni una sola partícula antes del final del tiempo… Visto desde fuera, tanto da que lo traguen o no, pero al menos, si no lo tragan mientras dura el tiempo, la información permanecería…

Elaboremos una nueva teoría; el horizonte de sucesos llega al borde del agujero al que solo podemos asomarnos. Entre él y la potencial singularidad hay una barrera temporal que no se podrá flanquear. La información de la estrella madre sigue en la caja fuerte y la llave puesta hasta el fin de los tiempos.

Con permiso de la evaporación.

domingo 8 junio, 2014 @ 2:38 pm

Si la complejidad computacional se comporta de manera similar a la gravedad, podemos decir que la materia oscura era en realidad materia gris extraterrestre?

domingo 8 junio, 2014 @ 7:38 pm

Estimado Radek:

Me consuela enormemente la frase donde se dice: «Sean «muros de fuego», gatos de «Schrödinger» o «cerebros de Boltzmann», lo importante no es si existen o no, sino que su existencia teórica pone en evidencia alguna contradicción interna de nuestras teorías, lo que permite el avance en Física Teórica».

Un cordial saludo.

miércoles 18 junio, 2014 @ 10:46 pm

Mi hipótesis es que los agujeros negros son huecos acumulándose todo el material captado en una cáscara que es más fina y con un radio mayor a medida que se incrementa dicho material captado. Aunque desde fuera el agujero negro muestre muchas características de una bola maciza. Esto plantea la necesidad de estudiar las características del hueco interior.

viernes 20 junio, 2014 @ 11:50 am

Estimado Joaquín Ruiz:

Pues no encuentro el hueco por parte alguna, ya que ha de ser mucho más denso y macizo que una estrella de neutrones; eso para los normales, es decir unas pocas veces la masa del Sol. Aunque parece ser que los supermasivos son millones de veces la masa solar y sin embargo su densidad media es algo así como la del agua, lo cual no consigo interiorizar. Supongo que en su interior tendrán algo tremendamente denso. Pero, en resumen, que de huecos no creo que tengan nada.

Saludos cordiales.

martes 24 junio, 2014 @ 7:29 am

A renglón de la conversación de Joaquín Ruiz y «tomás», tengo entendido que no son pocos los científicos que sostienen la hipótesis de que, en un tipo de agujeros negros (no recuerdo si en los supermasivos), la masa estaría tan concentrada y sometida a fuerzas gravitacionales tan intensas que se iría produciendo el decaimiento de partículas hasta quedar sólo neutrones.

Al final se acabaría produciendo el decaimiento de los neutrones con lo que no habría masa alguna, pero de algún modo persistiría la inmemsa distorsión de la curvatura espacio-tiempo.

De todos modos no soy experto en el tema y he podido meter la pata en algo, así que cualquier aclaración sería bienvenida.

martes 24 junio, 2014 @ 5:14 pm

«Por cierto, su charla versa, inexorablemente, sobre su incierto futuro…a punto de llegar, o eso creen»:

Ja, ja, ja…qué bueno, » petrus»!, muchas gracias por el relato, muy ocurrente.